Eltern werden doch nicht informiert

iOS 15.2: Nacktfoto-Erkennung wird abgemildert bereitgestellt

Als Apple Anfang August die Einführung neuer Kinderschutz-Funktionen ankündigte, unterschied der Konzern zwischen drei eigenständigen Initiativen.

Drei eigenständige Initiativen

Zum einen hatte man sich überlegt, dass die Sprachassistenz Siri und auch die Spotlight-Suche des Gerätes bei expliziten Suchanfragen intervenieren sollten. Wer sich auf Apples Endgeräten auf die Suche nach im Foto dokumentierter, sexueller Gewalt macht, sollte keine Suchergebnisse mehr sondern ein großes Stoppschild ausgegeben bekommen. Soweit, so unspektakulär.

Die zweite Säule, der Abgleich aller lokalen Fotos, die zum Upload in die iCloud vorgemerkt sind, mit einer Datenbank von digitalen Fingerabdrücken bekannter Missbrauchs-Bilder, sorgte hingegen für eine fulminante öffentliche Debatte. Diese sorgte Anfang September letztlich für die Verschiebung des Foto-Abgleichs auf einen unbestimmten Zeitpunkt. Doch auch darum soll es an dieser Stelle nicht gehen.

Nacktbild Erkennung in der Nachrichten-App

Wir blicken hier noch mal auf die dritte Säule der Kinderschutz-Funktionen: Die Nacktbild Erkennung in der Nachrichten-Applikation.

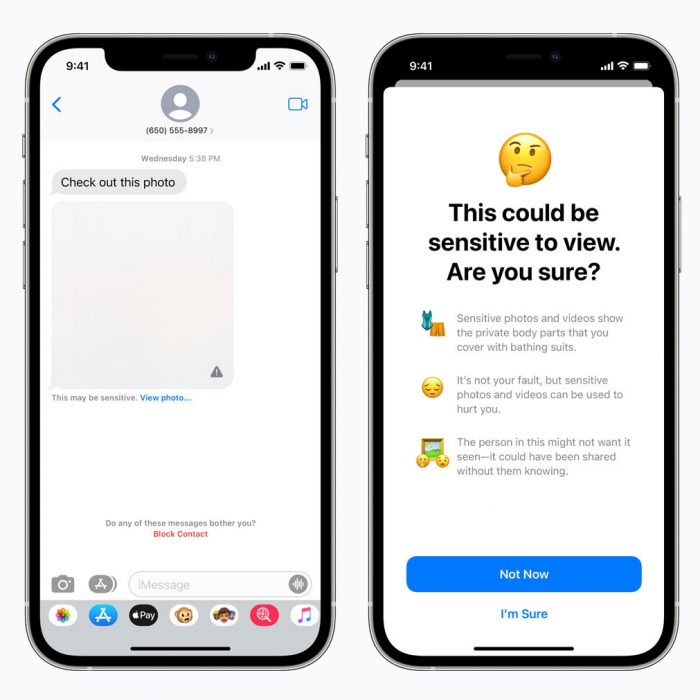

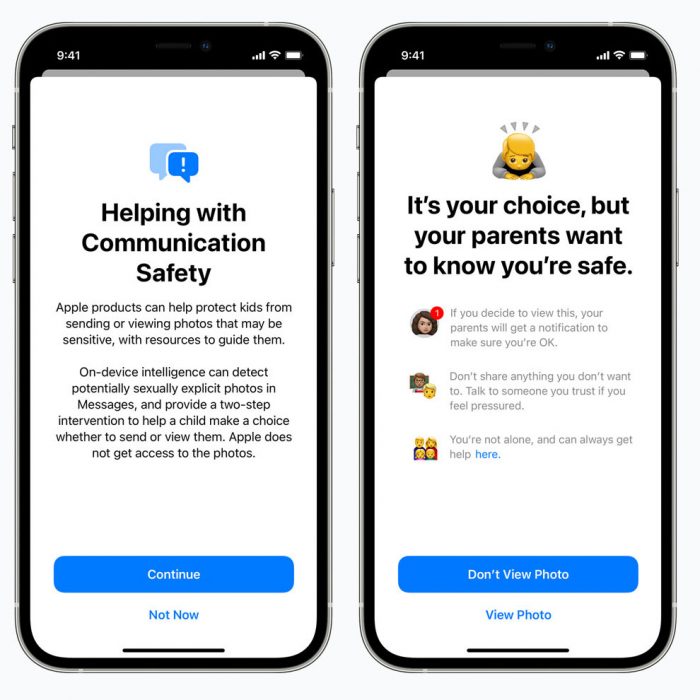

So hat Apple im August auch angekündigt, dass die ab Werk auf allen Geräten vorinstallierte iPhone-Applikation „Nachrichten“ auf den Smartphones minderjähriger Nutzer mit einer Nacktbild-Erkennung ausgestattet werden soll, die Empfänger vor unerwünschten Bildern schützen, diese verpixeln und erst nach einer zusätzlichen Nachfrage anzeigen wird.

Eine gute Idee, mit der sich relativ problemlos garantieren lässt, dass die Nachrichten-App die knisternden Fotos der aktuellen großen Sommerliebe durchlässt, übergriffige Kontakten aber keine Chance lässt, Minderjährige mit Penisbildern zu belästigen.

Was damals allerdings für (nachvollziehbare) Kritik von über 90 Interessengruppen sorgte: Apple hatte vor, Eltern darüber zu informieren, sollte der Nachwuchs die Rückfrage zur Bildanzeige positiv beantworten

Eltern werden doch nicht informiert

Hier hat Cupertino nun noch mal nachgebessert und wird die Nacktbild-Erkennung, deren Einführung die jüngste Beta von iOS 15.2 vorbereitet, ohne Rückfrage bei den Erziehungsberechtigten laufender Familienfreigaben ausrollen.

Mehrere Lobby-Organisationen hatten hier im Vorfeld gewarnt, dass diese Hinweise, je nach Familienklima, zu durchaus problematischen Situationen für die minderjährigen Anwender und Anwenderinnen führen könnten.

Ich hab’s jetzt aufmerksam gelesen aber nicht so ganz verstanden?!

Heißt jetzt der kritisierte „Scanner“ kommt demnächst oder nicht oder wird jetzt abgemildert ?

Kann ich jetz das neue iOS installieren ohne mir Gedanken zu machen, dass meine Bilder gescannt werden ???!

Apple ich weis nicht mehr um meinen Datenschutz bei euch … :(

Ja kommt

Nein kommt nicht. Es komm erst einmal nur der iMessage-Filter für

Kinder und der ist optional.

Den halte ich in der geplanten Form, ohne die Benachrichtigung der Eltern auch für sehr gut. Sollte aber nicht nur für Kinder angeboten werden, es gibt auch Frauen, die sich einen solchen Filter wünschen.

Ohne Benachrichtigung der Eltern ist gut??? Nein, gerade diese würde die Kinder unter 16 Jahre schützen!

Schutzalter in Deutschland 14, nicht 16.

Es gibt in gewissen Kulturkreisen Eltern, die ihre Kinder töten wenn diese bei vermeintlich „unsittlichen“ Handlungen erwischt werden.

Scanner (also Foto-Abgleich gegen Datenbank von Fingerabdrücken bekannter Missbrauchs-Fotos) befindet sich in der „Wir setzten uns noch mal damit auseinander“-Phase.

Einführung des (abgemilderten) Nacktbild-Stopp in der Nachrichten-App wird mit iOS 15.2 vorbereitet.

Zu den Interventionen in Siri und Spotlight gibt es noch nichts neues und keinen Termin.

Warum steht das denn nicht gleich so im Artikel, dass es jeder versteht?

Ich dachte der Code wäre schon in iOS 15?

Solange das ist wird es auch nicht installiert.

Sie arbeiten dran. Aber in gewisser Weise wird es wohl kommen.

Wie weiß aktuell nur Apple oder nicht mal genau die

Is iOS 15 denn mittlerweile fehlerfrei.

Dann Installiere ich iOS 15.1 jetzt und bleib für immer dabei

Da kann ich guten gewissens behaupten: Nein.

Ich hatte bis jetzt mit absolut keinem iOS irgendwelche Probleme und ich update immer ziemlich direkt nach Release.

Auch iOS 15 läuft seit Tag 1 problemlos

Von den Problemen liest man 99% nur im Internet. Tauchen in der Praxis so selten unter bestimmten Umständen auf das es quasi einen nie betrifft.

Fehlerfrei? Definitives, klares und eindeutiges Nein. Der am weitesten entwickelte Release der Vorversion – iOS 14.8.1 – ist ebenfalls immer noch Lichtjahre davon entfernt, fehlerfrei zu sein, sondern hat immer noch locker genügend Bugs, um täglich damit zu nerven. Beispielsweise die stark fehlerbehaftete Apple Watch Entsperrung, aber auch noch viele Weitere.

Fehlerfrei gibt es bei solchen Betriebssystemen gar nicht.

iOS 15.1 hat immer noch sehr, sehr viele Fehler, daran besteht kein Zweifel. Die Frage ist immer nur, ob die Bugs für dich halbwegs erträglich sind oder nicht. Das hängt von der Art der Nutzung ab und dazu gibt es sehr unterschiedliches Empfinden – ich würde mein iPhone nur im äußersten Notfall auf 15.1 „up“graden (z.B. falls Apple eine berechtigte Garantie ansonsten verweigert) und mindestens noch bis nächstes Jahr mit dem Update warten. Andere sind weit weniger anspruchsvoll mir der Stabilität und mit dem bereits jetzt gebotenen, für mich äußerst dürftigen Niveau zufrieden.

Bilder werden schon lange gescannt, gib mal Auto oder sowas in die Suche deiner Foto App ein. Gegen Kinderpornografie sollte mit allen technischen Mittel vorgegangen werden, scheiß auf „Datenschutz“ wenn ich das in dem Zusammenhang schon lese kommt mit dir Kotze! Wenn ich hier manche Kommentare lesen, wird mir wirklich übel. Da will man garnicht drüber nachdenken!!!

Na, dann sollte mal dein Rechner regelmäßig gescannt und geprüft werden. Denk‘ an die Kinder!

Und gar nicht wird gar nicht zusammengeschrieben!

[OT] Wie kommt es, dass ihr Apple immer als „Cupertino“ bezeichnet? BMW bezeichnet man doch auch nicht als „München“…?

Danke fürs Mitlesen. Zur Anmerkung: Hier ein wenig zu variieren macht den Text deutlich lesefreundlicher als drei Mal nacheinander Apple zu schreiben.

Und da wir uns vorwiegen auf Apple konzentrieren, wirst du hier auch immer wieder über den „Mac-Hersteller“, über „Cupertino“ oder über den „iPhone-Konzern“ und ähnliche Synonyme stolpern. Dabei geht es uns vor allem darum nicht mit Wortwiederholungen zu langweilen.

Und zur Frage BMW – München: Das Beispiel ist fast eine Nummer zu klein. Apple ist ja inzwischen fast so mächtig wie ein Land. Und auf die Aktionen von Ländern kann man durchaus mit Nennung der jeweiligen Hauptstadt referenzieren. „Moskau hat entschieden, dass…“ oder „Peking kritisiert, dass…“

So sehr ich für eine vielfältige und abwechslungsreiche Sprache bin, „Cupertino“ ist definitiv zu allgemein. Wenn die Stadtverwaltung von Cupertino einen Beschluss fasst, ist es sicher legitim, eine Meldung dazu auf den Namen der Stadt zu verkürzen, aber Apple ist nunmal nicht mit der Stadt gleichzusetzen, auch wenn es sicher das bekannteste Unternehmen dort ist. „Der Hardware-Hersteller aus Cupertino“ oder „der iPhone-Konzern in Cupertino“ lasse ich gelten, jedoch nicht eine solche Verkürzung.

Ich finds total okay und weiß was damit gemeint ist. Aber keine Ahnung ob sich ein „Cupertine“ in seiner Ehre verletzt fühlt ;-)

Kann ich mich nicht anschließen. Apple ist in Cupertino maßgeblicher Arbeitgeber, Mitgestalter und mehr.

Zudem gibt es eben Apples Deutschland, solle Irland usw. Und eben Apple Cupertino

Wird das nicht zunächst nicht nur in USA frei geschaltet und kann das abgeschaltet werden ?

Mich nervt das Synonym gehabe.. aber bin mit dieser Meinung wohl alleine

Diese Diskussion ist so unsinnig wie sonst nichts! Jeder weiß was im Text gemeint ist, da er sich auf Apple bezieht. Der hat ja auch eine Headline!

Also entweder Du verstehst das oder eben nicht und dann lies halt den Artikel nicht!

Ich gebe zurück ins Sende Studio nach München!

Wie @nicolas schon schreibt, gilt es den Text zu variieren. Und in einem Bericht über BMW kommt durchaus auch mal „die Münchner“ als Synonym vor.

Wer schon mal in der Bay Area war in Cupertino, der weiß, dass das mehr als Apple ist. Klar nimmt das UFO Headquarter einen Teil davon ein und Apple als Arbeitgeber groß, doch vorher war HP auf dem Gelände, auch ein riesengroßer Arbeitgeber.

Kommt auf den Zusammenhang an, in einen Artikel der nur über BMW geht wird es auch öfters mal nur so heißen wie sie Münchner, München etc. damit sofort raus gelesen werden kann dass dies eben direkt aus der Zentrale in München kommt und nicht aus einem anderen Werk das garnicht Konzernweit irgendwas beschließen kann

Das mit den Kinder schützen und Frauen vor unerwünschten dick pic’s find ich sehr gut (y)

Ich nicht!

Da jetzt bei dir keine Begründung stand, erspare ich mir meine auch.

Das muss man ernsthaft noch begründen? Das Versenden der Bilder ist in Deutschland strafbar und wenn man seine Kinder vor Straftaten schützt muss man das neuerdings begründen können?

Apple hat Kinder?

@T

Da weiß Mann gar nicht wo man anfangen möchte..

1. Ihr habt die ganze Diskussion der 70-80-90 alle verpennt? Stichwort Rasterfahndung. Das was Apple vorhat ist nichts anderes.

Ich fasse mal zusammen:

Es gibt nicht ineffizienteres, uneffektiveres als die Rasterfahndung.

Mal ganz abgesehen das Millionen Menschen in pauschal Verdacht genommen werden, quasi eine Verdachts unabhängige Durchsuchung (meines Eigentums/iPhone..iPad) und Ich dachte wir haben uns in allen Demokratien darauf geeinigt das prinzipielle die Unschuldsvermutung gilt und eine Durchsuchung immer von einem Richter angeordnet werden muss (das das schon nicht funktioniert ist ja nun auch nichts Neues)

In allen Fällen angefangen bei der RAF bis die heutige Video Gesichtserkennung an Bahnhöfen die die falsche/positiv Erkennung eine totale Katastrophe.

Technisch ist in der Regel entweder der Datensatz zu klein oder zu groß die Filter zu ungenau oder genau umgekehrt.

Was immer dazu führt das zu viele Daten entstehen (falsch/positiv) oder Daten durch den Filter rauschen.

2. Apple ist keine Behörde nicht meine Mutter oder Vater ich weiß selber was ich versende oder eben nicht.. das nennt man erwachsen.

Im Original Beitrag werden explizit Frauen angesprochen.. Hää gehts noch, meine Frau braucht auch keine behütete Umgebung.. die ist auch erwachsen.

Was Kinder angeht, sollte man lieber darüber nachdenken ob 4-5-10…?jährige Kinder überhaupt ein Handy brauchen.

Noch einmal falsch/positiv, zu ihren Algorithmen hat uns Apple natürlich wieder einmal nichts verraten.

Stichwort missbrauch, Gehacktes Gerät lasse ich mal.

3. Eltern werden informiert?

Ich möchte mal wissen, wenn ein 17. türkisches Mädchen (hier Berlin) ein Bild versendet, wo Papa, Bruder es alles anders sieht. Da wird dann auch schon mal die Tochter ermordet.. sicher drastisch, aber ja noch nie.. aus viel banaleren Dingen vorgekommen.

–/–

Es gibt noch etliche Argumente und ..

ich Denke ich habe den Rahmen hier bereits deutlich gesprengt.

+1

Man kann es nicht oft genug sagen….

Wa. Rasterfahndung?? Hast du den Artikel verstanden?

connectas. Das mit den türkischen Mädchen ist nur weil das Steinzeitmenschen sind mit einer Religion die so Steinzeit ist das es mit 90% der Welt nicht zusammenpasst. Selbst die im Busch sind intelligenter.

Solange meine Frau weiterhin dieses bekannte Meme mit dem Schwarzafrikaner an ihre Freundinnen schicken darf…

Mal ganz ehrlich wer glaubt denn daran das die Neugier nicht siegt und wie bei Cookie abfragen einfach auf ok geklickt wird. Das doch nur dazu da um dann zu sagen, jetzt müssen wir es doch umsetzen das die Elten benachrichtigt wird da die Kinder sorgenlos die Benachrichtigung anklicken. Also Ziel erfüllt nur mit Zwischenschritt oder sollte ich doch an den Osterhasen glauben..

Schutz ist ok aber ich halte den Scanner immer noch für nicht tragbar

Damit hat Apple aber seine Pflicht erfüllt. Das ist wie mit den FSK Hinweisen vor Filmen. Wenn zum Beispiel der Fernsehsender darauf hinweist, dass der Film erst ab 18 ist, ist es nicht mehr sein Problem, wenn der 12 jährige ihn sich ansieht.

Snowden. Du musst erstmal iCloud aktiviert haben damit irgendetwas lokal analysiert wird. Du laberst ein haufen Mist.

Wie wird denn in der Nachrichten-App die Nacktbilderkennung durchgeführt? Werden dafür alle einkommenden Bilder gescannt?

Ich versteh nicht, wie es sonst funktionieren soll.

Andererseits wollte Apple ja auf Scans vorerst verzichten, zumindest in der iCloud.

Weiss jemand genaueres?

Das macht eine KI. Die gibt es auch bei Microsoft in der Fotocloud. Diese kann -wohl sehr zuverlässig- Nacktbilder erkennen und verpixelt diese dann. Erst wenn Du zustimmst, wird das Bild dann angezeigt.

Die Bilder werden doch schon seit einiger Zeit vom iPhone gescannt, sobald sie in der Mediathek landen. Die Algorithmen erkennen dabei Gesichter, Tiere und andere Dinge, nach deren Stichwörter man suchen kann. Für Apple dürfte es daher nicht besonders schwer gewesen sein, entsprechende Algorithmen auch zu iMessage hinzuzufügen. Neu war in dem aktuellen Vorstoß nur, dass die Nachrichten-App eine Warnmeldung anzeigt und die Eltern informieren sollte, wenn ein Kind ein Nacktfoto anschaut.

Die Warnung an sich finde ich durchaus nicht verkehrt, denn längst nicht alle Kinder dürften sich der Gefahren im Netz bewusst sein, sei es, weil sie von den Eltern diesbezüglich alleine gelassen werden, oder weil sie ein elterliches Verbot gezielt umgehen möchten. Meiner Meinung haben Kinder jedenfalls genauso ein Recht auf Privatsphäre, daher ist ein „Verpfeifen“ an die Eltern definitiv nicht in Ordnung.

Apple hat diesbezüglich nachgebessert, so verbleibt die Entscheidung, eine solche Aufnahme anzusehen oder nicht, bei den Kindern, gleichzeitig erhalten sie Hinweise, was sie tun können, falls sie unaufgefordert gesendete Nachrichten erhalten und diese nicht möchten. Die angedachten Scans für in die iCloud hochzuladenden Dateien haben damit erstmal nichts zu tun, die sind ja eher dazu gedacht, Apple davor zu schützen, dass illegales Material auf deren Servern landet.

Die Dateien in der Cloud selbst werden ja ebenfalls schon seit langem gescannt, daher könnte der Scan genauso gut bereits vor dem Upload stattfinden. Hier stellt sich allerdings wiederum die datenschutzrechtliche Frage („Was auf meinem iPhone passiert, bleibt auf meinem iPhone.“), denn es kann nicht sein, dass private Daten gescannt werden und bei Positivfunden Apple-Mitarbeiter die Dateien sichten und Meldungen an die Behörden verschickt werden.

Rein technisch würde es ausreichen, wenn das iPhone die Daten lokal mit den Prüfsummen indizierter Aufnahmen abgleicht und solche Bilder dann explizit vom Upload ausschließt. Apple würde damit Ressourcen auf den Servern sparen und gleichzeitig sicherstellen, dass illegales Material erst gar nicht dort landet, aber der Nutzer hätte weiterhin Gewissheit, dass seine Daten privat bleiben (und man könnte im gleichen Zug sämtliche iCloud-Daten Ende-zu-Ende verschlüsseln, so dass erst gar keine Begehrlichkeiten von außerhalb aufkommen).

Einkommende Bilder werden lokal auf dem Gerät mit AI analysiert (gleich wie die Fotos app Gesichter und z.b. Hunde erkennt)

Wenn die AI ein Nacktbild erkennt, wird der user vor dem Öffnen jenes Bildes gewarnt.

Das andere Feature, welche Fotos für die iCloud Fotomediathek auf dem Gerät nach u.a. Kinderpornos durchsucht, kommt vorerst nicht.

Wobei man hier anmerken muss, dass eigentlich alle cloud Anbieter dies schon machen, einfach in der cloud und nicht auf dem Gerät des Users.

Ah

Snowden

Du hast anscheinend noch nicht verstanden das nur die Bilder lokal durchsucht werden die auf icloud hochgeladen werden.

Die meisten solchen Bilder Kommen aber per snap, Telegram, WhatsApp, Twitter DM etc. Da nützt so ein Filter nur für die Nachrichten app herzlich wenig..

Genau das hab ich auch gedacht. Mein Jüngster, hat glaube ich, noch nie die Nachrichten-App genutz!

Das mag hier in Deutschland so sein. Aber in Amerika schaut das ganz anders aus. Da wird die Nachrichten App von Apple viel intensiver genutzt als bei uns.

Dabei ist die Nachrichten App der schwächste Messenger. Lausige Usability, mieser Funktionsumfang..

Oder man hält bei FaceTime ein Foto vor die Kamera, zieht sich aus o.ä. Wird das bald auch alles gefiltert?

Willkommen in Afghanistan!

Ja, hier schon, aber nicht in den USA. Da wird es mehr genutzt.

Liebe Mitleser,

dass Thema im Artikel ist viel weitreichender und wichtiger als die Diskussion um Synonyme eines Unternehmens bzw. um deren Hauptsitz.

Der Scanner kann sofort in die „Dieser Mißt hat auf meinem Gerät nichts zu suchen“ Phase überführt werden. Solche Technologien werden mehr Schaden einrichten als sie vermeintlich verhindern sollen. Da hat Apple echt komplett versagt.

Es ist schon bezeichnend dass andere immer besser wissen was gut für mich ist. Diese Bevormundung mag ich überhaupt nicht ich habe selber einen Kopf und gesunden Menschenverstand und entscheide selber, ich denke diese Entscheidung sollte man der jeweiligen Person überlassen und nicht technisch eingreifen

Und wieder einmal beweist Apple, dass ihr Gerede vom Datenschutz eben nur Gerede ist. Ähnlich wie ihr Umweltschutz, weshalb sie keine Ladegeräte mehr dazu geben, dafür aber ein usb-c Kabel. Das mit ihrer neuen Aktion der Überwachung offiziell Tür und Tor für alle möglichen Scans privater Fotos geöffnet wird, scheint hier mal wieder ziemlich egal zu sein. Da müsste man sich ja auch mit dem Totschlagargument Kinder/Frauen auseinandersetzen. Naja, Android ist ja bestimmt noch viel schlimmer…

Android sammelt nicht nur Daten sondern sehr viele Daten auf jeder Ebene.

Es ist ein optimaler Kinderschutzfilter, der Nacktbilder erkennen kann. Das kann jede bessere KI auf jeden Smartphone und tangiert den Datenschutz überhaupt nicht, da keine Daten irgendwohin gesendet werden.

Und genau dorthin geht nun Apple auch, Hetel.

Und das nicht erst seit dem Photoscan. Ich erwähne an dieser Stelle beispielsweise den Siri-Skandal, bei welchem Apple-Mitarbeiter Siri-Befehle nicht nur auf den Apple-Servern speicherten, sondern auch gleich auswerteten.

Ob sich letzteres inzwischen geändert hat, ist mir nicht bekannt, da ich bis heute über keine entgegenstehende Informationen verfüge.

Und es ist (mir) letztlich auch völlig schnuppe, denn: wer einmal lügt, dem glaub ICH nicht. …

Die meisten Kinder 99% sind doch bei WhatsApp , in 1 % iMessage

1% bei WhatsApp

Eher bei Snapchat. Also so blöd sind die Kinder nicht, sie werden schon einen Weg finden, das zu umgehen. In meiner Kindheit sagten wir ja auch: „Wo ein Wille ist, ist auch ein Gebüsch“ ;-)

Du weißt aber schon, dass das primäre Ziel von Apple Amerika ist? Und das dort ein ganz anderes Nutzungs-Verhältnis der Nachrichten Apps existiert als bei uns?

Wenn der Versand von dick pics eine Straftat darstellt, dann kann diese in einem Rechtsstaat ja angezeigt werden (es geht mir jetzt um erwachsene Sender und Empfänger), was hat Apple damit zu tun? Die Post scannt ja auch nicht alle Briefe und sucht darin nach irgendwelchen verbotenen Inhalten. DHL öffnet auch nicht alle Pakete und guckt rein.

@conectas: Bevor Du Dir die Mühe machst und soviel schreibst: LIS den Artikel noch einmal richtig!

Es gibt keine Info an die Eltern, es werden auch keine Behörden informiert. Es ist ein einfacher Kinderschutzfilter.

„Rasterfahndung“ … ich fasse es nicht *Kopfschütteln*

Ich fasse es nicht wie hier manche argumentieren. Welche Daten sollen denn hier nicht geschützt werden? Die Fotos werden schon jetzt per AI gescannt. Man kann nach Personen und Gegenstände und auch Pflanzen und anderes suchen. Warum sollte es nicht möglich gemacht werden einen Warnhinweise zu schalten, wenn die AI ein Foto mit einem unangemessenen Motiv für das jeweilige Alter erkennt. Manche haben offenbar nicht verstanden was technisch passiert.