Alle CSAM-Hinweise komplett entfernt

Missbrauchs-Erkennung: Apple tilgt Ankündigung aus dem Netz [Update]

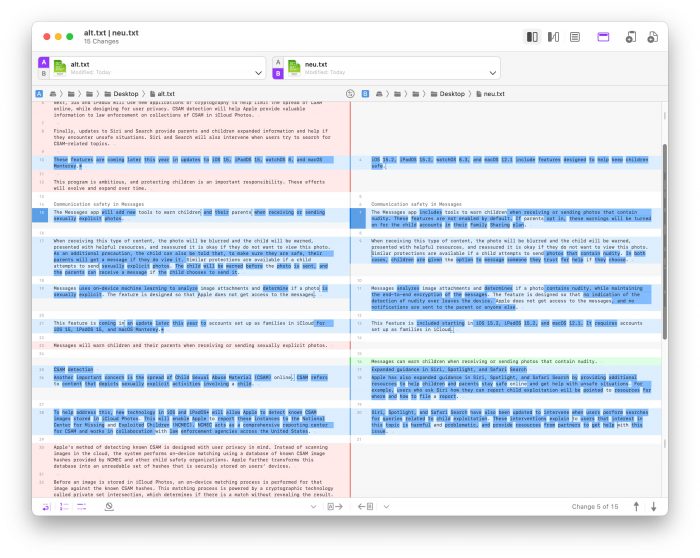

Im Anschluss an die Ausgabe der jüngsten iOS-Aktualisierung auf Version 15.2 hat Apple die Sonderseite „Erweiterter Schutz für Kinder“ grundlegend überarbeitet und hier jegliche Verweise auf die baldige Einführung einer Missbrauchs-Erkennung entfernt.

Während Apple hier bislang noch über die hauseigenen Pläne informierte, zukünftig alle zum Upload in die iCloud vorgemerkten Fotos auf das Vorhandensein möglicher Missbrauchsmotive hin zu prüfen, taucht der Hinweis auf die geplante Suche nach „Child Sexual Abuse Material“, sogenannten CSAM-Bildern, nun überhaupt nicht mehr auf der Sonderseite auf.

Alle CSAM-Hinweise (und PDFs) entfernt

Dabei hat Apple nicht nur den Volltext ordentlich zusammengestrichen, sondern auch die Links auf die zahlreichen PDF-Veröffentlichungen entfernt, die auf der Übersichtsseite bislang zum Download angeboten wurden und technische Hintergründe zu Apples Vorgehensweise bei der Suche nach CSAM-Bildern skizzierten.

Seit Apples Ankündigung, an der Einführung eines lokalen Bild-Scanners zu arbeiten, sah sich das Projekt massiver Kritik ausgesetzt. Vor allem die Tatsache, dass Apple den Scan auf die Geräte seiner Anwender auslagerte und hier verdachtsunabhängig alle Bilder vor dem Upload von intelligenten Algorithmen prüfen wollte, stieß auf Kritik.

Apple hat den bisherigen Text stark zusammengestrichen

Sorge vor Missbrauch der Missbrauchserkennung

Apple, so der Vorwurf von Journalisten, Bundestagsabgeordneten, Bürgerrechtlern und Anwälten, würde damit eine Infrastruktur schaffen, die schnell für Begehrlichkeiten in autoritären Regimen sorgen würde. Apple könnte nicht garantieren, das die so etablierten technischen Voraussetzungen langfristig nicht auch zur Suche nach regierungskritischem Material eingesetzt werden würden.

Nun sind alle Hinweise auf den CSAM-Scan verschwunden. Auf der überarbeiteten Seite verweist Apple nur noch auf die mit iOS 15.2 eingeführte Nacktbilderkennung in der Nachrichten-App und die Interventionen von Siri und der Safari-Suche, wenn Anwender versuchen nach Missbrauchsbilder zu suchen.

Apple selbst hat sich zum Hintergrund der Überarbeitung noch nicht offiziell geäußert und lässt damit im unklaren, ob und wann es mit der implementierung eines CSAM-Scanners in iPhone und iPad weitergehen wird.

Alle Artikel, die wir bislang zum Thema verfasst haben könnt ihr in unserem Nachrichten-Archiv unter dem Schlagwort CSAM nachlesen. Hier eine Auswahl:

- Gegen die Bilderkennung in iMessage: Über 90 Lobby-Gruppen appellieren

- Mindestens 30 Fotos: Apple präzisiert Missbrauchs-Erkennung

- Apples geplante Fotoscans sorgen auch intern für massive Kritik

- Kinderporno-Scan: Apples Antworten lassen viele Fragen offen

- Apple-Kritik aus dem Bundestag: Lokaler Foto-Abgleich ein „Dammbruch“

- Offener Brief: „Apple-Überwachung verstößt gegen Pressefreiheit“

Update von 18:30 Uhr: Gegenüber „The Verge“ hat ein Apple-Sprecher angegeben, dass die Sprachregelung vom 3. September weiterhin aktuell sei. Damals hatte Apple die Einführung der Funktion bis auf Weiteres verschoben und dies folgendermaßen begründet:

Wir haben bereits Pläne für Funktionen angekündigt, die dazu beitragen sollen, Kinder vor Räubern zu schützen, die Kommunikationstools nutzen, um sie anzuwerben und auszubeuten, und die Verbreitung von Material über sexuellen Kindesmissbrauch einzudämmen. Aufgrund des Feedbacks von Kunden, Interessengruppen, Forschern und anderen haben wir beschlossen, uns in den kommenden Monaten mehr Zeit zu nehmen, um Anregungen zu sammeln und Verbesserungen vorzunehmen, bevor wir diese äußerst wichtigen Funktionen zum Schutz von Kindern veröffentlichen.

Können gleich damit weitermachen, Dieben die Erkennung von AirTags in deren Nähe zu ermöglichen. Deswegen habe ich die AirTags nämlich gekauft. Hätte ich das vorher gewusst, hätte ich nicht mal darüber nachgedacht die AirTags zu kaufen.

Ist zwar ein wenig weg vom Thema, hilft aber vielleicht weiter. Die einfache Faustregel für die AirTags lautet: Hilfe in Situationen in denen Objekte verloren oder verlegt wurden. Keine Hilfe bei gestohlenen Objekten und Gegenständen.

Das habe ich aber erst nach dem Kauf erfahren.

Kann es sein, dass du dann nicht richtig aufgepasste hast oder es überlesen hast? Das war doch von Anfang an klar, dass es für diese Szenarien gar nicht gedacht oder konstruiert war. Also mir zumindest.

Tech Nick, wer blind kauft, ist selbst schuld. Sorry.

Das war doch von Anfang an bekannt, dass die einen Stalking-Schutz haben und deshalb als Diebstahlschutz nicht taugen.

Heißt das, dass das erstmal von Tisch ist? Gibt es denn Möglichkeiten für Dritte irgendwie zu prüfen ob das Apple nicht doch unter dem Radar einführt? Möglicherweise würde das ohne offizielle Ankündigung und Anpassung der. AGBs dann gar keinen Sinn machen, weil ein ausschlagen des Mechanismus dann vor Gericht dann eh kein Bestand hätte? Beziehungsweise nicht als Beweis genutzt werden könnte.

Solange nichts offizielles gibt gibt es halt nichts offizielles.

Bringt nur nichts wenn die Code Zeilen nicht vollständig entfernt werden.

Der nicht funktionierende Prototyp ist ja immer noch im Code von iOS 14 vorhanden.

Schwer bei Closed Source zu sagen. Sind nur Spekulationen und der Code kann zukünftig auch entfernt werden.

Sind alles nur Vermutungen. Deshalb hätte ich mir hier eine saubere Kommunikation von Apple gewünscht, statt einfach nur den Text runterzunehmen.

Das wird genauso klammheimlich verschwinden wie AirPower und ähnliche Applegurken, die nie das Licht der Welt erblickt haben. Dann werden sie noch „verbessert“ und erscheinen „später“, und ganz plötzlich sind sie für immer weg.

hoffe nicht. War der richtige Weg. Jetzt scannt man dann halt die Cloud und gibt die Verschlüsselung auf…

Bilder waren in der cloud noch nie verschlüsselt

Doch schon immer, aber die Daten waren noch nie so verschlüsselt, dass diese von Apple nicht gelesen werden könnten.

Wahrscheinlich schon integriert. Kann ja eh niemand nachprüfen.

Warum sollte man es nicht überprüfen können?

Weil iOS proprietäre Software ist.

Und trotzdem kann man es überprüfen. Mal ganz davon abgesehen, dass die Bilder nach US-Recht gerichtlich nicht verwertbar wären, wenn Apple es heimlich machen würde.

Könntet ihr einen Hinweis auf euer eingesetztes Programm geben, mit dem ihr die Alt-Neu-Gegenüberstellung im Bild oben visualisiert?

Kaleidoscope.app

Es wird auf jeden Fall kommen, da die EU gerade gegen Apples Privat Relay massiv vorgeht und Apple unterstellt, nicht genug zum Schutz der Kinder zu unternehmen. Apple muss aktuell vortragen, wie man diesen Umstand verbessern könne. Es ist also nur noch eine Frage der Zeit. Nur muss dann nicht wieder jeder anfangen, auf Apple mit dem Finger zu zeigen.

Ja, ich finde dieser Aspekt gehört eigentlich mit in den Artikel. Im Internet berichten andere bereits seit Tagen darüber. Ist hier wohl noch keinem weiter aufgefallen. Passiert.

Das war damals schon der Fall das die EU Druck gemacht hat. Hat hier auch niemanden interessiert.

Ja das krasse ist dabei Ja das sie nur schon im Vorfeld was bereitstellen wollten was die EU bald vorschreibt! Willkommen im …

Apple, so mein Eindruck, hat aufgehört sich nur irgendwelche Gedanken über die Auswirkungen deren schwachsinnigen Ideen zu machen. Das die überhaupt über die pauschale suche auf Geräten der Nutzer durchführen wollten, und das so massiv gepusht haben, zwingt mich zu denken, dass das ganze auf gar kein Fall mit angekündigten Ziel zu tun haben kann. So blöd werden sie doch nicht sein, dachte ich. Das ist doch ein offenes Tor für sämtliche Nachrichtendienste und Polizei, und die ganzen Prinzen und sonst wen.