Massive ARKit-Verbesserungen ab 2019

Bloomberg: iPhone-Rückseite zukünftig mit 3D-Sensor

Bis zur Integration des neuen Kamera-Moduls sollen zwar noch rund zwei Jahre vergehen, doch schon jetzt arbeiten Apples Ingenieure an einem neuen 3D-Sensor, der auf der Rückseite zukünftiger iPhone-Modelle platziert, für eine detailliertere Erfassung der Umgebung sorgen soll.

Dies berichtet die Finanznachrichten-Agentur Bloomberg unter Berufung auf mit der Angelegenheit vertraute Quellen. Nachdem das iPhone X mit seiner nach vorne ausgerichteten TrueDepth-Kamera bereits die verlässliche Erkennung von Entfernungen bietet, soll auch die Rückseite des Gerätes zukünftig detaillierte Umgebungseindrücke sammeln können.

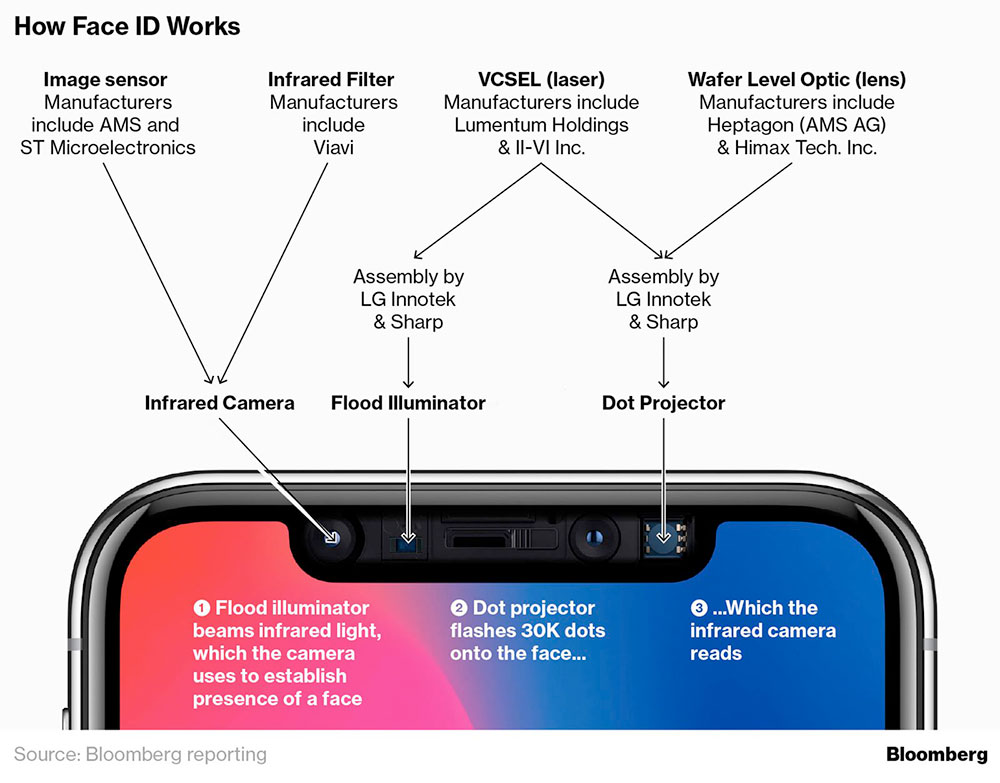

Laut Bloomberg will Apple das räumliche Sehvermögen des iPhones jedoch mit einer anderen Technik realisieren als der, die momentan in der Gesichtserkennung Face ID zum Einsatz kommt. Statt auf 30.000 Licht-Punkte zu setzen, die Face ID beim Kartografieren der (Gesichts)-Oberfläche helfen, soll die Rückkamera zukünftiger iPhone-Modelle auf eine Laufzeitmessung setzen:

[…] The existing system relies on a structured-light technique that projects a pattern of 30,000 laser dots onto a user’s face and measures the distortion to generate an accurate 3-D image for authentication. The planned rear-facing sensor would instead use a time-of-flight approach that calculates the time it takes for a laser to bounce off surrounding objects to create a three-dimensional picture of the environment.

Die neuen 3D-Sensoren sollen langfristig dabei helfen die Funktionsweise der ARKit-Applikationen optimieren, die schon jetzt in der Lage sind Oberflächen zu erkennen, zu vermessen und virtuelle Objekte auf diesen zu platzieren.

Man könnte das Essen im Urlaub besser fotografieren…

Aber mal Spaß beiseite, als Fotografie-Hilfe wäre es sinnvoll einsetzbar.

Wozu braucht man sowas in seinem iPhone? Zumal die ganzen Kinder sowieso nur WhatsApp und Games drauf haben. Jedes Jahr Preisen die Smartphone Hersteller ihre „ach so tollen kameras“ an, aber außer für nette Schnappschüsse wird die Kamera eh nicht verwendet. Wozu also brauch ich eine 3D Kamera in einem telefon ?

Sowas kann man von mir aus in einem iPad unterbringen, da iPads in der Regel produktiv benutzt werden. Und noch eine Idee: wie wäre es mal wenn Apple die miserable Kamera in den MacBooks verbessert ? DA würde ich eine bessere Kamera wirklich begrüßen, da ich durchaus oft Konferenzen online führe. Aber nein: wir brauchen hyper 3D Kameras in den iPhones damit jeder Hipster sein Essen oder sein Outfit fotografieren kann, nur um die Fotos dann in mieser Qualität auf Instagram hochladen zu können. Geil! Setzen , sechs !

Siehst, es gibt nicht nur Dich. Jeder hat andere Anforderungen an seine Hardware.

Mir ist zum Beispiel die Kamera im MacBook egal. Ich will eine sehr gute Kamera im Handy.

Und nun?

OK. Und nun sag mir doch bitte, was du so tolles mit deiner Handy-Kamera machst? Ich hätte gerne eine bessere Kamera an meinem COMPUTER, da ich damit Geld verdiene. Und du so? Dass du Geld mit Fotografie verdienst, kann sein. Aber dann wärst du eher Profi und würdest sicherlich nicht mit einer Smartphone-Kamera rumlaufen. Was mich zu meiner zweiten These bringen würde: Rein Künstlerich mag es sein, das du gute Motive findest und Fotos machst. Und um diese dann mit der „Welt“ zu teilen lädst du sie entweder bei Face oder bei Instagram oder sonstigen Seiten – komprimiert – hoch. Wo also die Qualität einer „sehr guten Kamera“ eh nicht viel bringt. Drittes Szenario: Du ergötzt dich den Fotos auf den kleinen Bildschirmen – wo allgemein jedes Foto sehr gut aussieht – und bist einfach ein glücklicher, aber dummer Konsument.

Ich glaube, da ist mein Wunsch nach einer besseren Kamera in meinem Arbeitsgerät womit ich Konferenzen halte und mehrere Firmen leite doch etwas Praxisnäher.

Professioneller Stripper? Gibt doch gute 4K Kameras, die man zum Streamen nutzen kann ;)

@ M1LL10N4R3

Nach Deiner etwas merkwürdigen Argumentation könnte ich Dich nun fragen, wozu Du ausgerechnet für Video-Konferenzen eine bessere Kamera brauchst. Ich nutze mein MacBook Pro (2012) auch sehr oft zu diesem Zweck, aber ich hatte noch nie den Wunsch nach einer besseren Kamera. Meist wird die Qualität des Videos sowieso durch eine instabile Internetverbindungen oder ebenfalls durch Komprimierung verschlechtert.

Mal eine Bemerkung abseits des Themas. Wenn man zur Verstärkung seiner schwachen Argumente, Phrasen wie „womit ich Konferenzen halte und mehrere Firmen leite“ verwenden muss, wirkt das nicht glaubwürdiger. Wenn Du mehrere Firmen leiten müsstest, dann hättest Du eher ein professionelles Video-Konferenzsystem und kein Notebook. ;)

@ Millionaire (oder so):

Du erscheinst Dir sehr wichtig. Ich bin stolz, mit Dir gemeinsam hier posten zu dürfen. Bitte verlasse uns Unwissende nicht …

Oh deine Meinung ist wichtiger?..was n Mensch.

Meinung lesen. Akzeptieren. Fertig. Seine Ansicht kannst du ihm nicht wegnehmen.

Wenn Du mehrere Firmen leiten müsstest, dann hättest Du eher ein professionelles Video-Konferenzsystem und kein Notebook……

und er würde sich nicht in einem Forum M1LL10N4R3 nennen, aber vermutlich so L33t das er täglich seine Konferenz um 13:37 startet.

Typischer Kommentar der „Mein höchstpersönlicher use case ist nicht abgedeckt, ist also doof.“-Fraktion. Setzen, sechs.

Oh ja! Wenn ich eine Baufirma beauftrage das sie mir eine Wand hochziehen oder sonstige Sachen bauen, gewinne ich unheimliches Vertrauen wenn der Bauleiter ein iPhone rausholt und damit die Räume bemisst! Geh zurück in deinen Sandkasten und lass die Erwachsenen mal reden.

Nee, um Vertrauen zu gewinnen müsste er wenn schon sein iPad rausholen und damit dann Fotos machen :-D

Keine Umgangsformen, Beispiele völlig an der Realität vorbei…. da kann ich Dich leider nicht wirklich ernst nehmen.

Dich kann man überhaupt nicht ernst nehmen. Haust hier auf den Putz, was du alles machst und tust. Hast aber leider keinerlei Ungangsformen oder Anstand und skizzierst uns allen nur deine egozentrische Weltsicht. Danke. Zurück zur Kamera…

In deinem Nickname fehlt ne 1…

Nein tut es nicht.

Öhm… Doch…!

Der Nick ist sowas von 90er… Leetspeak ist einfach nicht mehr „cool“ und zeugt auch nicht von besonderem IT-Wissen ;)

Oder ne 3 zuviel…

Nicht zu viel, aber an der falschen Stelle…

Dohoch. Entweder ist es deutsch „Millionär“ oder englisch „millionaire“. Aber nicht millionare. Aber du bist ja grad mit Firmen leiten beschäftigt. :-D

Boah… da spricht wieder einer, der überhaupt keine Ahnung von AR hat…

Der Kutscher war auch der Meinung, das Auto würde sich auf gar keinen Fall durchsetzen! Zu teuer, zu gefährlich…

Also ehrlich gesagt wäre ich schockiert wenn Apple daran NICHT arbeiten würde…

@ Horst: mag daran liegen das ich ein 90er Bub bin ;-)

Bin ein 80er Bub… Siehe Nickname… Ob das „cool“ ist, oder seiner Meinung nach „nicht von IT Wissen zeugt“, ist mir vollkommen egal… Zeugt bei ihm eher von ausgeprägten Vorurteilen… :)

Trotzdem stimmt der Nickname so leider nicht… ;)

@ Phantom: ich betreibe mehrere Webseiten und Firmen. Wenn ich auf Reisen bin, habe ich nun mal mein MacBook dabei und arbeite damit. Ich denke, dafür sind die Teile ja schließlich da, oder ? Aber kommt, vergiss es! Ich merke schon das hier überwiegend nur Spielkinder unterwegs sind. Ich bin als Pro-Consumer vielleicht am falschen Ort. Viel Spaß noch mit euren hyper 3D Kameras. Sind natürlich wichtig um animierte Emojis noch realistischer wirken zu lassen

Doch genau dafür sind diese entwickelt worden!

Aber mal ganz ehrlich, so ein Pro scheinst du gar nicht zu sein, wenn du dann doch in öffentlichen Foren versuchst dich zu beweisen.

Sei doch von Anfang an so seriös und geh arbeiten oder Urlaub machen.

Das Beispiel mit dem Vermesser der sein Smartphone rausholt, ist ein sehr realitätsfernes Beispiel. Da ich glaube, dass kein seriöser Mensch ein Vermesser mit einem Smartphone als Werkzeug ins Haus holen würde. Und wenn doch, selbst Schuld.

btw in naher Zukunft werden die iDevices auch solche feinen Messungen Möglich machen können. Warte noch ein bisschen.

Wenn ich dann jetzt doch mal auf die Aussage seiner (Millonare, Millionar ) Beiträge eingehe, fällt mir folgendes auf:

Kodak ist mit der Eigenentwicklung der Digitalkamera komplett untergegangen, weil es für sie Spielerei war und keinen Nutzen hatte…

Microsoft (Steve Ballmer) hat über das iPhone gelacht und ist mit seiner Sparte an Smartphones untergegangen…

Das sind für mich zwei Beispiele an Engstirnigkeit, die seine Aussagen eigentlich nur unterstreichen, denn für ihn hat es ja keinen Nutzen… ;) Die Zeit wird es, wie immer, wohl brachial entlarven… :)

Ooooh, ich verspüre stark negative Schwingungen und sehr viel Frust. Keine Angst, das gibt sich wieder und alles wird wieder gut. Wenn es dennoch schlimmer wird, ist das auch durchaus erfolgreich therapierbar. Jetzt mal ehrlich, ich konnte bei der Keynote auch nur mit den Augen rollen, als animierte Emojis mit solcher Begeisterung präsentiert wurde. Letztlich habe ich aber nur geschmunzelt und tue mir sicher selbst einen Gefallen, dass gelassen zu sehen – Ich muß es weder mögen noch nutzen wollen, es zeigt aber Möglichkeiten auf. Ich lese hier seit 10 Jahren sehr viel und schreibe sehr wenig. Zugegeben, manchmal sinkt das Niveau der Kommentare so stark, dass ich einfach nicht mehr gewillt bin, meine Zeit hier durch weiter Lesen weiter zu verschwenden. Es zwingt mich ja auch keiner dazu und ich tue es trotzdem oft und gern und erfahre hier oft sehr interessante Anregungen, auch und gerade in den Kommentaren. Sehr schade finde ich jedoch immer, wenn der sonst sehr informative Kommentarbereich durch Beschimpfungen und Beleidigungen abgleitet. Man sagt doch, wenn Kinder spielen, sind sie gesund. Ich persönlich finde spielende Kinder toll und spiele gern mit und habe Spass. So gesehen ist das wort Spielkinder eigentlich gar nicht negativ vorbesetzt. Aus Kontext heraus ergibt sich jedoch ein ganz anderer, eher beleidigender Eindruck. Wenn ich mich daraufhin noch Mal in den Kommentaren zu diesem imho durchaus nicht uninteressanten Thema umschaue, sehe ich jedoch nur ein Kind, das wohl eher bockig und verzogen jetzt darunter leidet, dass ihm seine Eltern nicht bei Zeiten angemessene Umgangsformen beigebracht wurden und nun keiner mehr mit ihm spielen will.

Krasser pro-consumer bist du. Da können alle anderen hier natürlich nur die falsche Meinung haben. Sind ja alles bur „dumme Konsumenten“. Fettes Stirnklatsch. Hier laufen welche rum…

Nur mal so am Rande ich leite keine Firma, hab auch keine 3 Autos mit Car Play. Besitze auch kein Haus mit 5 iMacs.

Und verdiene auch keine 50000€ im Monat. Aber ich liebe mein iPhone und iPad und benutze beide Kameras viel und gerne.

Aber wen ich hier die Kommentare immer lese, denke ich das hier nur Millionäre schreiben!

Ha ha schönen Abend noch !

Ich glaube nicht, dass Apple, oder sonst eine Firma, es noch einmal schafft, ein revolutionäres Feature rauszubringen, was alle Menschen erreicht.

Eine 3D-Erfassung macht aus meiner Sicht bei der rückseitigen Kamera mehr Sinn als bei der Selfiecam.

Wie es Aussieht, wenn ein Bauunternehmer auf der Baustelle mit dem iPhone etwas aufmisst, mag für manche Leute wichtig sein. Für mich wäre es wichtiger, wie genau die Erfassung ist. In zwei Jahren könnte die Technik für eine einfache Massenermittlung ausreichend sein.

Ich würde diese Kamera mit auf meine Wunschliste für den Nachfolger des SE setzen.

Der Umgangston ist hier leider echt zum weinen. Mit treibt das hier regelmäßig den Puls in die Höhe … nur will ich den Menschen die wertvolle Beiträge Posten die Chance geben gelesen zu werden. Nur überwiegen hier immer öfters Kleinkriege. Warum soll eine gute Kamera fürs iPhone nicht sinnvoll sein? Wenn ich gerade keine große Kamera zur Hand habe und kann einen wertvollen Moment einfangen ist dies unbezahlbar. Zum 3D vermessen … professionell muss das garnicht sein aber die IKEA App hat mir zuhause schon mal geholfen, um mir vorzustellen wie meine Möbel aussehen werden. Warum sollte ich das nicht begrüßen wenn das alles noch genauer abläuft.

Das kann man nur begrüßen, wenn man Ikea-Käufer ist und kein „Pro-Consumer“, der mehrere Firmen betreibt und oft Online-Konferenzen führt.