Kleiner Speicher, große Sprachmodelle

KI auf Mobilgeräten: Apple-Forscher melden Durchbruch

Um so genannte Large Language Modelle (LLM), also die künstlich intelligenten Sprachgeneratoren vom Typ ChatGPT, lokal und ohne Internetverbindung auf den eigenen Geräten einsetzen zu können wird eine vergleichsweise performante Hardware benötigt.

Für lokale Sprachmodelle

Zum Ausführen der Sprachmodelle sind dabei nicht unbedingt schnelle Prozessoren erforderlich, sondern vor allem ein üppiger Vorrat an freiem Arbeitsspeicher. Dieser ist auf Mobilgeräten wie dem iPhone bekanntlich Mangelware. Selbst Apples aktuellstes iPhone-Modell, das iPhone 15 Pro, verfügt „nur“ über acht Gigabyte Arbeitsspeicher.

Als entsprechend signifikant darf die Veröffentlichung eingestuft werden, die ein Team von Wissenschaftlern um Apples Machine-Learning-Ingenieure Mehrdad Farajtabar, Keivan Alizadeh und Ahsen Khaliq jetzt in Form eines Papers freigegeben hat.

Dabei haben Apples Ingenieure und Forscher eine Methode entwickelt, um große Sprachmodelle auch auf Geräten mit begrenztem DRAM effizient zu betreiben. Grob vereinfacht, werden die Modellparameter dabei auf dem Flash-Speicher schwachbrüstiger Endgeräte gesichert und nur bei Bedarf in den Arbeitsspeicher geladen.

4- bis 25-mal schneller als bisher

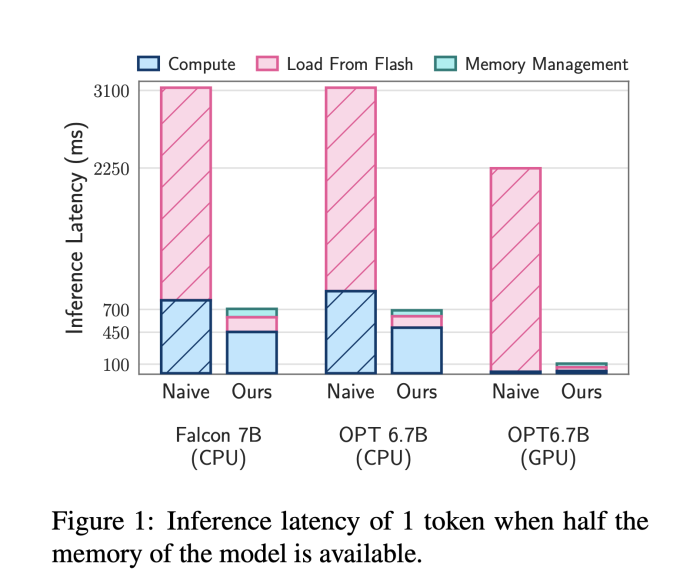

Als Durchbruch darf die Art und Weise beschrieben werden, wie auf die Daten zugegriffen wird. Hier haben die Wissenschaftler ein Modell entwickelt, das voraussagt, welche Parameter als Nächstes benötigt werden und können diese so schnell und effizient von der Festplatte der Mobilgeräte in deren Arbeitsspeicher überführen.

Dank dieser neuen Techniken ist es den Forschern gelungen, lokale KI-Modelle zu nutzen, die doppelt so groß wie der verfügbare Arbeitsspeicher sind. Zudem kann auf die für deren Ausführung benötigten Informationen 4- bis 25-mal schneller als bisher zugegriffen werden. Unterm Strich sind so die Möglichkeiten geschaffen, auch große Sprachmodelle auf Endgeräten mit begrenztem Speicher effektiv nutzen zu können.

Das „Internet der Dinge“ wird zur „Intelligenz der Dinge“!

Lokales Sprachmodell was für mich alles analysiert (die Daten die ich freigebe) und eigenständig agiert mit Einsicht wäre ein Träumchen.

Das wäre genial, wenn Apple das hinbekommt!

Puh. Das wird aber richtig cool (technologisch betrachtet)

Oder einfach mal mehr Arbeitsspeicher verbauen? Die Android Liga macht das bereits. Mein iPhone Mini 13 ist für mich das ideale Gerät – merke aber immer wieder das 6 oder 8 GB dem Gerät gut getan hätten, anstatt 4.

Vom Formfaktor her dürfte das drin gewesen sein.

also mir ist Effizienz wichtiger und ist das was Apple schon immer macht.

In einen Formel 1 Wagen ein Raketentriebwerk einzubauen, macht einen auch nicht zum Weltmeister.

Schließe ich vollkommen an. Bin extra noch kurz vor iPhone 15 Release von iPhone 12 Mini auf 13 Mini gewechselt weil ich auch persönlich finde dass es der beste Formfaktor ist. Hoffentlich kehrt Apple irgendwann wieder zu kleineren iPhones zurück auch wenn es aktuell nicht gut aussieht.

Größe ist nicht alles. Auf die Technik kommt es an. Hab ich mal gehört.

Mehr RAM, mehr Stromverbrauch

Immer dieses rumgejammer nach mehr Speicher, anstatt das die Hersteller vernünftig programmieren. Windows mit MacOS zu vergleichen mit 8 GB RAM ist genauso idiotisch, wie Android mit iOS zu vergleichen. Mac schneidet Hörbücher besser ab, weil das Sstem dahinter viel ressourcenschonender arbeitet. Allein Dell mit ihrem Icore 5 die heiß werden und der Lüfter schreit, daneben das MacBook/Air, das spielt in einer ganz anderen Liga.

Ich persönlich freue mich auf Apple GPT. Wenn das dann auch noch auf meinem iPhone 15 pro funktioniert wäre das wirklich top!

Schön, dann ist Google mit Gemini nicht mehr alleine mit lokalen KIs. Jetzt muss Apple die Forschung nur noch umsetzen

Gemini

Ist nicht lokal (nicht die „richtige“ Version).

Die lokale Version ist (offenbar) lahm und vor allem begrenzt

Naja wenigstens schon verfügbar und lahmer als die bisherigen Möglichkeiten kann’s ja nicht sein…

Apple hat das Swapping erfunden :)

Nö, das gibt es bereits seit den 60ern.

Tatsächlich hat Apple Swapping bereits viele Jahre vor Windows genutzt.

Aber das eigentlich auch nur, weil Windows (3.0) erst 1990 herauskam.

Unix nutzt es quasi schon immer und damit der Mac eben halt schon ewig.

MacOS nutzt heutzutage sogar mehrere SwapFiles, aus Effizienzgründen.

Habe ich mir auch beim Lesen gedacht. :)

Denn ist es ja endlich bewiesen, dass man viel Hirn braucht um auch intelligent zu … was wollte ich sagen? ;-)

Und sicher so doof wie Siri