Transparenz-Probleme

Stress-Test: Der Porträt-Modus des iPhone 7 Plus

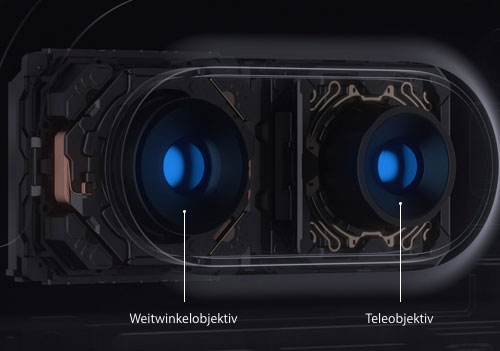

Abgesehen vom größeren Display und dem kraftvolleren Akku wirbt das iPhone 7 Plus in diesem Jahr vor allem mit zwei Kamera-Funktionen um potentielle Käufer: Dem optischen 2x-Zoom, der über das integrierte Tele-Objektiv realisiert wird und dem Porträt-Modus mit Schärfentiefe-Effekt.

Letzteren hatte Apple zur Vorstellung der neuen Geräte-Generation zwar noch nicht im Kasten, bietet seit der Freigabe von iOS 10.1 nun aber immerhin eine erste Beta-Version des experimentellen Features an, die sich alle iPhone 7 Plus-Besitzer aus dem Netz laden und im Alltagseinsatz ausprobieren können.

Apple schreibt:

Mit der Schärfentiefe kannst du Gesichter scharf aufnehmen, während im Hintergrund ein Unschärfeeffekt entsteht. Wenn du ein Foto mit dem iPhone 7 Plus machst, nutzt das Dual-Kamerasystem beide Kameras und fortschrittliches maschinelles Lernen, damit dein Motiv gestochen scharf ist, während im Hintergrund der gleiche Unschärfeeffekt – bekannt als Bokeh-Effekt – erzeugt wird, der normalerweise bei einer Spiegelreflexkamera entsteht. Es ist also egal, wie der Hintergrund aussieht, deine Porträts sehen ganz einfach gut aus.

Ein Versprechen, dem Brian Moore jetzt im Rahmen seines Stress-Tests auf den Grund gegangen ist. Moore wollte wissen, welche Grenzen der neuen Foto-Funktion gesetzt sind: Welche Motive bringen die Automatik durcheinander (schaut euch nur die links und rechts weichgezeichnete Schnur des Affen in unserem Header-Bild an)? Wie geht Apples Schärfentiefe-Funktion mit Aufnahmen um, die mehr als eine Person im Bildvordergrund abbilden.

Brian Moore zeigt: Schärfentiefe-Funktion und transparente Objekte

Eine spannende und reichlich bebilderte Bestandsaufnahme, die ihr euch hier zu Gemüte führen könnt.

While a lot is super good, there are a couple areas where the Portrait Mode just ain’t gonna cut it. Complicated foreground and background combinations seemingly overwhelm it and the blur edges get confused throughout the photo. Portrait Mode doesn’t even begin to successfully work with translucent or shiny objects. Though this is pretty understandable considering the hardware — attempting to detect depth on objects like these is probably difficult. Not sure if Apple will ever be able to get over this one unless their machine learning becomes near-perfect.

Ihr meint wohl eher den „Portät“-Modus, wie ihn Apple peinlicherweise genannt hat. Hat Apple noch so etwas wie eine Qualitätssicherung?

Wurde abgeschafft. Die Aufgaben hat Siri übernommen

Oh ja da kann man sich ja auch schließlich jahrelange darüber aufregen.

Ahh…Punisher ist auch so ein Weichspüler bei dem die zweite Linse versagt hat ;-) Sehr konstruktiver Beitrag.

@ Jörg

Und Jetzt nenn mir mal den sinnlichen Nährwert von Deinem Müllbeitrag.

Sinnlich…na wenn Du es sinnlich brauchst bist Du bei mir falsch.

Oh, auch noch begriffsstutzig. Sorry, ich hätte sie besser nicht ansprechen sollen.

Ich finde de Fehler nicht schlimm dass man mal ein Schreibfehler in der Beta hat, aber wozu gebe ich denn die Feedbackfunktion in der ich in jeder Public Beta auf den Fehler hingewiesen habe, wie viele andere auch. Dann dachte ich ok Prioritäten sind anders gesteckt, aber als dann die Final rauskommt mit dem Fehler ist es wirklich etwas Peinlich. In den Einstellungen steht es auch einmal falsch und einmal richtig. Das ist keine Tageszeitung wo der Text nur durch drei Hände geht.

Die sollten für jede Sprache einen Muttersprachler in der QS einsetzen. Dann bewerbe ich mich. Jetzt muss ich nur aufpassen, dass ich keinen Rechtschreibfehler reinbringe.

*reinbringe ?

Na ja, wegen einem fehlenden Buchstaben… Ich muss gestehen, auch mir fallen solche Fehler oftmals nicht direkt auf. Das menschliche Auge bzw. das Gehirn erfasst laut Studie nicht die einzelnen Buchstaben, sondern den das erste und letzte Zeichen. Die restlichen Buchstaben können auch miteinander vertauscht werden, wir können es trotzdem gut lesen. Siehe folgendes Beispiel:

„Afugrnud enier Sduite an enier Elingshcen Unvirestiät ist es eagl, in wlehcer Rienhnelfoge die Bcuhtsbaen in eniem Wrot sethen, das enizg wcihitge dbaei ist, dsas der estre und lzete Bcuhtsbae am rcihgiten Paltz snid. Der Rset knan ttolaer Bölsdinn sien, und du knasnt es torztedm onhe Porbelme lseen. Das ghet dseahlb, wiel wir nchit Bcuhtsbae für Bcuhtsbae enizlen lseen, snodren Wröetr als Gnaezs.“

Top Text – sehr beeindruckend

Ihc fdine das Bspieeil speur.

Noch einer der angebliche Studien wiedergibt, welche auch schon oft widerlegt wurden. Viel Spaß mit folgendem text: Daß der bei witeem götßre Tiel der Mncsheen (drutaner das gznae shncöe Gcsehclhet) den Scritht zur Menikügidt, außer dem daß er birhlcsweceh ist, acuh für sher giechräflh hatle

dfüar seogrn shocn jnee Vonerümdr, die die Ocfrashuibet üebr sie gsgütit auf scih gmmeeonn heban. Ndhceam sie ihr Hieavush zsuret dmum gcmaeht hbean und sifrtolägg vhtüeteren, daß dsiee rheiugn Göpsfcehe ja kneein Shrtcit aeßur dem Gelagegwänn, darin sie sie enrpeetisrn, weagn dtufern, so zgeein sie ihnen nechhar die Gaefhr, die inehn droht, wenn sie es vrecusehn alieln zu gheen. Nun ist deise Gefhar zawr eben so gorß nchit, denn sie wrüedn durch eagimniel Faelln whol edlcnih gheen lneern; aleiln ein Bpiesiel von der Art mhcat doch srcüechhtn und sccrekht giihmenen von aleln feerrnen Vserehcun ab.

Und falls der text immer noch zu einfach ist: Bbnsghhceeunftloiraee ist eher schwer lesbar, Bcuhstbaenrehenifloge klappt dagegen. Ist aber beides das gleiche Wort.

ne, die is in Urlaub. Aufgrund dessen ist der riesen Fehler passiert, in einer Sprache, von 50(?), einen Buchstaben vergessen zu haben.

Die QS schlug doch schon bei dir in Form deiner Eltern fehl…also wozu der Aufstand?

Mal Butter bei die Fische – hier gehts immer noch um ein Smartphone – nicht um eine digitale Spiegelreflexcamera! Die Qualität die Telefone zum Thema Fotografieren mittlerweile bieten ist doch der Wahnsinn! Und wer mehr möchte soll sich eben eine System- oder Spiegelreflexcamera kaufen und nicht immer meckern was ein Telefon alles nicht so gut kann!

Dann soll man aber eine solche Funktion auch nicht als Killer-Feature bewerben. Dann muss man sich nicht wundern, wenn Kritik kommt.

Gesichter sind in aller Regel auch nicht transparent und dafür ist diese Funktion da, was auch nie anders behauptet wurde.

Hier meckert niemand, es sollen nur die Grenzen aufgezeigt werden.

Ups .. „Ich“ natürlich.

ntüralcih stolle es „ntüralcih“ hissen…

Es ist und bleibt ein berechneter Effekt, Wunder sind nicht zu erwarten.

Letztendlich ist das dieselbige Funktion wie sie Sony schon vor mehr als einem halben Jahrzehnt in seine HX9v-Knipse als „Background Defocus“ gepackt hat (dort mit Zusammenrechnen zweier hintereinander geschossener Fotos und nicht parallel wie beim iPhone), aber mit den analogen Limitierungen.

Einschränkungen sind zu erwarten falls Szene zu dunkel oder zu hell, Objekt sich bewegt, Objekt ist zu weit weg oder zu klein, hat selbe Farbe wie der Hintergrund oder ist transparent oder einfach zu nahe am Hintergrund.

Und trotzdem eine nette Funktion, die ich (immer noch) gerne einsetze, mit der Zeit bekommt man ein Gefühl was geht und was nicht und bleibt trotzdem erstaunt, was mit einfacher Technik und bisschen Software doch möglich ist und genauso sehe ich diesen Modus beim iP7p.

Wer mehr will, muss auch mehr mitschleppen.

Um den vergleich iPhone vs. Spiegelreflex aufzugreifen. Meine, wohlgemerkt Einsteiger Kamera „Canon EOS 600D“ liegt seitdem ich das iPhone 6/6S und nun das 7 Plus habe nur noch im Schrank. Die Qualität genügt mit und schneller geht`s auch.

Dann hast du damit nicht Fotografiert sondern die 600D nur als Knipse missbraucht. Keine Ahnung, warum du dir die gute Kamera geholt hast, aber ich wette du bist noch nie losgegangen mit dem einzigen Ziel Fotos zu machen.

Ich würde niemals auf die Idee kommen, ey ich nehme jetzt mein iPhone7 um von dir ein Portrait anzufertigen. Der Modus ist schrott und wird noch schrottiger sobald die Kanten zu wenig Kontrast haben. Nur auf dem ersten Blick sehen die Bilder toll aus, aber nach ein paar Sekunden ist dann jedesmal etwas komisches dran. Hier zum Beispiel die Schnur an dem sich der Affe festhält.

Ich habe schon ein paar mal erlebt, wenn die Benutzer wissen wie sie richtig gute Bilder mit ihrer Spiegelreflexkamera produzieren, sind sie zum einem total begeistert sind und zum anderen lassen sie das Handy viel öfter in der Tasche.

Dann kannst du wohl einfach nicht fotografieren und rennst zusätzlich mit einem billigen Kit Objektiv umher!

Das ist ähnlich wie die Live-Photos. Erstmal eine ganz nette Idee, aber in der Praxis oft nicht optimal.

Ich kann mir mit der Doppellinse viele interessante Ideen vorstellen, z.B.:

Ausschneiden des Hintergrunds bei Videos und einblenden der Videos ins Live-Bild. Obi wan Kenobi lässt grüßen und Apple wäre in der augmented reality angekommen.

Konnte das Note4 schon vor zwei Jahren. Nur wesentlich besser.

Super jetzt kann ich Fotos machen aber der Rest ist doch nur Schrott, mit jedem Update gibt es mehr Probleme bei Bluetooth. Nach dem Koppel geht alles einmal, dann geht die Hälfte wieder nicht und jedes mal geht etwas anderes nicht. Heute kam im Auto ein anruf über das 7Plus rein, die Ansage anrufer unbekannt, die Rufnummer stand aber im Display des Autoradio. Das Gespräch konnte aber nicht angenommen werden, das 7 Plus klingelte in der Hosentasche weiter. Da sollte man meinen das jetzt auf der App eine 1 steht für verpassenden Anrufer nein das war nicht der Fall, in der Anrufliste stand die Rufnummer rot drin. Beim nächsten fahren wurde per BT nur das Telefonbuch übertragen die Anruferlisten aber nicht. Beim nächsten fahren wurden die Titel der Musik nicht mehr übertragen aber abgespielt, konnte aber nicht vorwärts springen. Der Witz ein Android funktioniert einwand frei.

Für mich ist das reine GELDMACHEREI…!

Der Akku hält auch nicht viel länger als bei dem kleinen.

Habe es getestet.