In den AirPods-Einstellungen

Neu in iOS 16: Personalisiertes 3D-Audio mit Ohren-Scan

Hinter euch im Raum fällt ein Glas zu Boden. Obwohl ihr eure Augen gerade ganz woanders hattet, könnt ihr binnen Sekundenbruchteilen jedoch eindeutig zuordnen, ob das Glas eher links oder eher rechts hinter euch zu Bruch gegangen ist. Warum?

Individuelle Kopfform wird erfasst

Grob vereinfacht macht sich das Gehirn unter anderem die Laufzeitverzögerungen zu Nutze, die das Schallereignis benötigt, um bei euren Ohren anzukommen. Ging das Glas eher links hinter euch zu Bruch erreicht das Klirren zuerst das linke und dann das rechte Ohr. Die wenigen Millisekunden Differenz reichen dem Gehirn dann schon aus, um die ungefähre Position der Geräuschquelle zu ermitteln.

Neue Situation: Jetzt habt ihr Kopfhörer auf, die euch mit dem 3D-Klang eines zu Bruch gehenden Glases überraschen wollen. Wie lässt ich dessen virtuelle Position im Klang Punktgenau festlegen? Hier kann man sich zwar ungefähr der menschlichen Wahrnehmung annähern, würde aufgrund der vielen unterschiedlichen Kopfformen aber nie genau die individuelle Wahrnehmung eines jeden Anwenders treffen. Dies will Apple mit iOS 16 ändern.

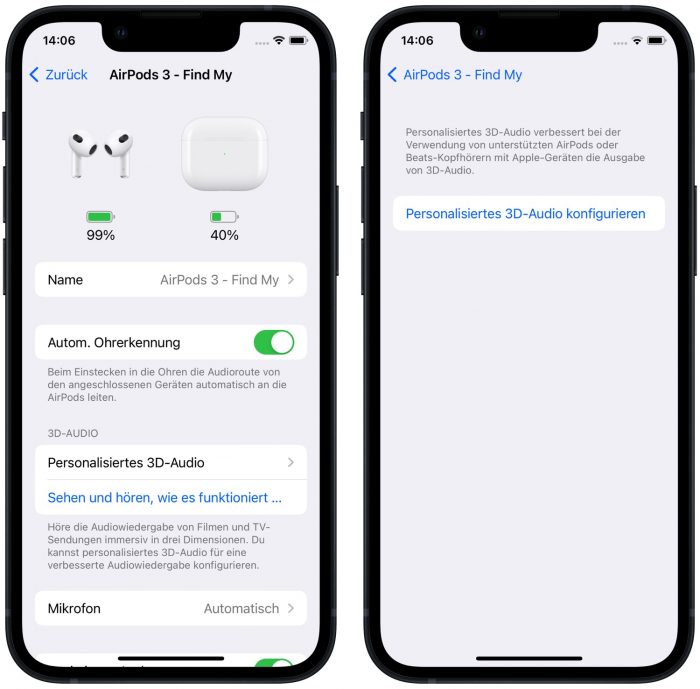

In den AirPods-Einstellungen

In den Einstellungen der AirPods-Kopfhörer hat das neue Betriebssystem dafür nun einen neuen Bereich integriert, der die Konfiguration von personalisiertem 3D-Audio zulässt.

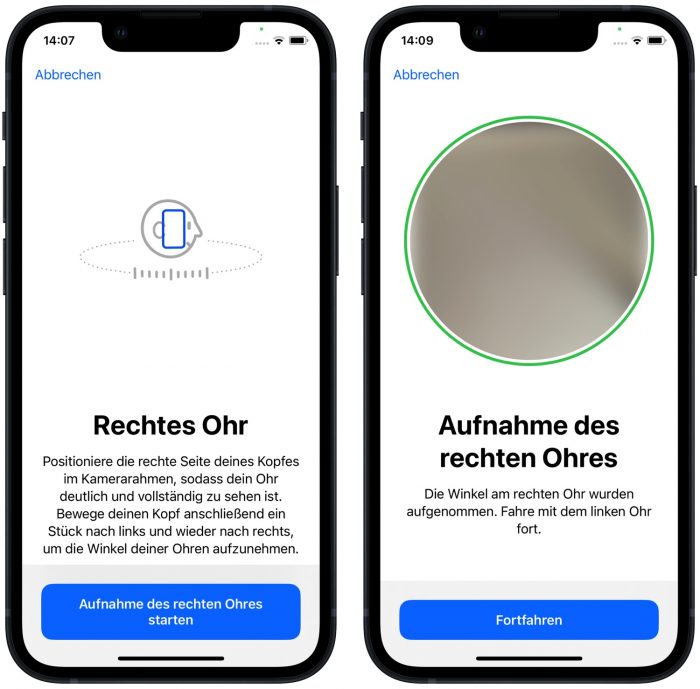

Dafür scannt das Face-ID-Modul aktueller iPhone-Modelle nicht nur das Gesicht seines Besitzers, sondern auch die Ohren des iPhone-Nutzers, um auf Grundlage der so ermittelten Werte ein exaktes Akustik-Modell erstellen zu können und letztlich die Möglichkeit zu haben 3D-Klänge deutlich individueller als bislang ausliefern zu können.

Es ist davon auszugehen, dass Apple sich hier die sogenannte Head-Related Transfer Function zunutze macht. Wie hörbar die Auswirkungen der neuen Funktion sind, muss jedoch noch abgewartet werden.

unglaublich was heute alles möglich ist. Dann lassen wir uns einmal überraschen, ob es dann auch etwas bringt…

Ich find’s auch einfach mega, dass Apple womöglich das ganze Potential der AirPods raus holt ;)

Das macht Sony zwar schon lange, aber ok. Unglaublich…

früher Irgendwann (80er / 70er..?) gab es sogar schon mal eine Aufnahmetechnik, bei der einfach 2 Mikros (also Stereo) in die Ohren eines nachgebauten Kopfes gesteckt wurden und bei Studioaufnahmen genutzt wurde um in Stereo einen Raumklang nachbilden zu können.

hab es damals in einem Museum (Siemens-Museum ggf.) via Kopfhörer gehört. War damals schon echt genial und täuschend echt.

Muss gewesen sein, bevor Dolby sich durchgesetzt hat.

Fänd es cool, wenn das jetzt wieder aufleben lässt.

Gibt es heute noch genauso. Nennt sich Kunstkopf- oder binaurale Aufnahme. Ist jedoch blöd, da solche Aufnahmen nur für Kopfhörer und nicht für Lautsprecher geeignet sind.

Es gibt auch schon länger Inears, die nach Ohrvermessung in einem Studio mit einem speziellen Klangprofil versehen werden können. Wenn Apple eine gute Methode für diese Vermessung hinbekommen hat, wäre das sehr spannend.

ist diese funktion denn schon in der aktuellen public beta enthalten?

Es gibt noch keine public beta.

Ja, ist es

Bin sehr gespannt. Aktuell reißt mich 3D Audio leider nicht vom Hocker.

Gib dir mal Virtual Hairdresser (Binaural Audio) bei YouTube (aber über Kopfhörer!), is ne Kunstkopfaufnahme die ich sehr beeindruckend finde. Und das ohne Kopf einmessen und irgendwelche 3D-Audio -voraussetzenden Kopfhörer.

Ach du kennst das auch. Siehe oben :D

vor allem geht das alles mit reinen Stereo-Kopfhörern, keine aufwändige Surround Technik etc.

ob das die Industrie so gut fände..?

Wenn man Hörspiele damit hört, merkt man den Unterschied sehr genau.

Ich sehe mich bereits schielend in dem Versuch zu erkennen ob mein Ohr jetzt erfasst wird oder nicht

War auch mein erster Gedanke… :-D

Mir ist völlig unklar, inwieweit das Nutzen haben soll. Die Dinger sitzen ja in den Ohren, da ist die Form der Dinger doch völlig Banane oder will er durch den Scan ermitteln, wie deren Form den Tonfluss beeinträchtigen und das dann berücksichtigen? Kann mir nicht vorstellen, dass das so viel Auswirkung hat, aber lasse mich gerne überraschen.

Es geht darum was und wie die Kopfhörer den Sound ausgeben, nicht um deren Form. Bei verschiedene Kopfformen können verschiedene Laufzeitverzögerung und ggf Filter bei den einzelnen Geräuschquellen im Ausgangsmaterial angewendet werden um ein möglichst realistischen 3D-Effekt zu erzeugen. Lies dir mal was zu Binaural Audio durch wenn’s dich interessiert.;)

Hoffentlich werden diese Biometriedaten entsprechend sicher und geschützt gespeichert.

Ja genau…. es könnte ja jemanden geben der sich unbedingt dein innenOhr nachbauen will

Weiß man, wann ungefähr die nächste Generation der AirPods Pro kommen soll?

genau das gibt es bei Sony Kopfhörern auch schon beim Active Noise Canceling.

Ich persönlich konnte aber noch keine Veränderung zu vorher nachher feststellen.

Soweit ich weiß hat das nichts mit dem ANC zu tuen sondern mit 3D-Audio. Bei Sony also 360.

Auch müssen die Apps das dann unterstützen. Deezer ist z.B damit kompatibel. Die Daten des Scans werden dann an die App übergeben die dann das Audio entsprechend aufbereitet ausgibt…

Das ist dann aber keine HRTF!

Aber vielleicht klappt ein optischer Scan ja auch ein bisschen…

Geht aber in die Richtung… Gerade die ITD kann ja so bestimmt werden.

gibt es schon seit über einem Jahr bei den sony XM 1000- 2

hab da auch nie einen Sinn gesehen

Ja, es bringt was bei den AirPods Max … großartiger Klang zusammen mit Dolby Atmos über Apple Music. Definitiv besserer Sound als über Spotify.

Definitiv – mit den AirPods Max ein Traum :)

Sorry das macht alles keinen Sinn

Es werden vielmehr Daten für zukünftige Apple Air pods gesammelt.

Grund: die Geräuschquelle ist im Gehörgang. Man müsste wenn dann den Abstand zwischen Quelle und Trommelfell messen. Kopfform oder Ohrformen sind sehr relevant für das räumliche Hören, aber nur wenn die Quelle des Tons außerhalb ist.

Ist der „Ohrenscan“ auch kompatibel mit den Ohren von Prince Charles ?

Möglicherweise soll nun auch das sehr individuelle Ohr abfotografiert werden, für eine zukünftige polizeiliche Identifikation. So wie zuvor schon der Fingerabdruck (Fingerprint Sensor) und der Gesichtsscan (Face ID). Wer weiss,wo die Körperscans von Millionen Menschen (iPhone Besitzer) weltweit gespeichert werden und wozu?