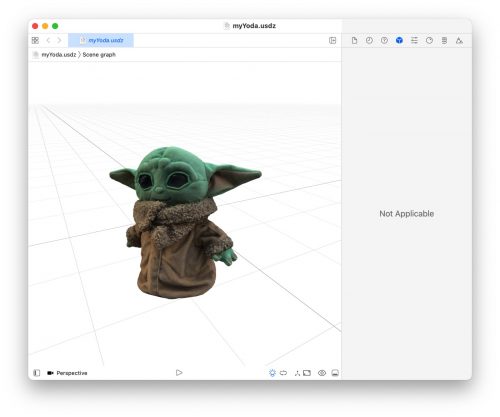

Objekterfassung mit Yoda-Stoffpuppe

Beeindruckend hochwertig: 3D-Objekterfassung mit iPhone und Mac

Die neue „Object Capture“-Funktion, die iOS 15 und macOS 12 Hand in Hand anbieten werden, war Apple so wichtig, dass diese sogar während der diesjährigen WWDC-Keynote berücksichtigt wurde – auf den Vorschauseiten von iOS 15 und macOS 12 ist die neue 3D-Funktion allerdings nur mit einem Satz vertreten.

Hier beschreibt Apple die jüngste Erweiterung der seit Jahren aggressiv vorangetriebenen Augmented-Reality-Anstrengungen des Konzerns folgendermaßen: „Verwandeln Sie eine Reihe von 2D-Bildern in ein fotorealistisches 3D-Objekt, das für AR optimiert ist – in nur wenigen Minuten.“

Genauer wird Apple in Sachen Objekterfassung dann in der WWDC-Videosession 10076. Unter der Überschrift „Create 3D models with Object Capture“ gehen die Apple-Ingenieure Michael Patrick Johnson und Dave McKinnon hier auf die Details ein, die bedacht werden müssen um nur mit Mac und iPhone bewaffnet nahezu perfekte 3D-Modelle zu erstellen.

Modell-Erstellung benötigt zahlreiche Fotos

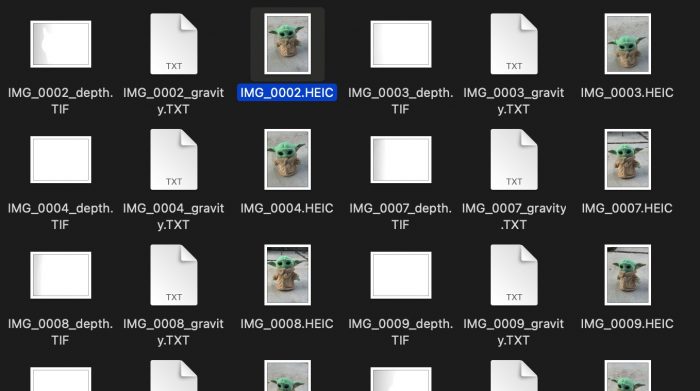

Was hier als erstes auffällt: Die Anzahl der Fotos, die für vorzeigbare Ergebnisse benötigt werden, ist massiv. Im Video beschreiben die Apple-Entwickler das Beispiel eines Turnschuhs, der über 120 mal mit einem iPhone 12 Pro Max abgelichtet wurde, um über ausreichen Fotos für die programmatische Erstellung des 3D-Modells zu verfügen.

Welche Ergebnisse hier unter Alltagsbedingungen möglich sind, zeigt iOS-Entwickler Matt Waller am Beispiel einer Yoda-Stoffpuppe.

Mit Hilfe von 85 Schnappschüssen und den von Apple bereitgestellten Werkzeuge zur Modell-Erstellung hat Waller ein Augmented-Reality-Modell der Puppe erstellt, das erstaunlich detailreich, hochaufgelöst und nahezu nahtlos frei im Raum rotiert und skaliert werden kann.

Die so erstellte, knapp 15 Megabyte große .usdz-Datei hat Matt Waller über sein Dropbox-Konto zum Download bereitgestellt. Welche Schritte vom ersten Fotos bis zum fertigen Modell nötig waren, beschreibt der Entwickler in diesem Blog-Eintrag.

Echt cool.

geht das nur mit den macs und iPhone 12 Modellen?

Und vorallem geht das auch ohne den lidar sensor?

Glaub net

Kann ich das Photo als Grundlage für ein 3D-Modell nutzen, um es über den 3D-Drucker auszudrucken. Was meint Ihr?

Theoretisch ja, die Technik gibt es ja schon etliche Jahre.

Praktisch: keine Ahnung.

Mich wundert, dass so viele Fotos benötigt werden. In der Keynote sah es aus, als ob vielleicht 8 Fotos ausreichen.

Das wird Photogrammetrie sein und benötigt keine. lidarsensor, der übrigends furchtbare ergebnisse liefert, gegenüber rein auf Foto basierenden Programmen die teils noch Kostenlos sind.

Ich freue mich darauf wenn es von Apple eine entsprechende funktion von Hausaus geben wird.

Ohne Lidar geht da nix.

@Blackpool Doch, braucht kein LiDAR

Leute, schaut doch einfach in den Artikel…

So it turns out that you can take pictures with your phone and then you send them to your Mac and … not just any Mac … Either M1 or it needs 4 GB AMD and 16 GB of RAM.

…

I have an iPhone XS, which has the dual camera on the back that can read depth.

Hi,

Geht doch jetzt schon

ZB mit Trnio – die App macht auch gleich die Bilder und es braucht k e i n e n LIDAR Sensor

Allerdings läuft es über upload und dauert ein wenig bis zur Datei

Grundlagen wie möglichst unstrukturierter Hintergrund sollten für gute Ergebnisse bekannt sein.

Weiß jemand, ob man daraus STEP, IGES oder STL auf dem iPhone oder Mac exportieren kann?

Tja, wenn das so weitergeht haben wir in ein paar Jahren eine 1 zu 1 Kopie unserer Liebsten in der Garage…

:))

Kurzer Nerd-Hinweis: bei der Puppe handelt es sich nicht um Yoda, sondern Grogu (aus der Mandalorianserie) ;)

Danke !

Grogu ist aber Yoda, nur eben als Baby. Den Namen ändert er erst im Alter.

Danke für den Spoiler

Grogu ist nicht Yoda, da „The Mandalorian“ nach „Rückkehr der Yedi Ritter“ spielt, und da ist Yoda gestorben.

Aha, und deswegen Spielt die Serie auch nach der Zerstörung des Todesstern. Da ist Meister Yoda schon Tod. Nix Baby Yoda

Tino das stimmt nicht, Mandalorian spielt 5 Jahre nach Episiode 6 (Rückkehr der Jediritter) und 42 Jahre nach Episode 1 (Eine dunkle Bedrohung), ist jedoch 25 Jahre vor den Ereignissen von Episode 7 (Das Erwachen der Macht). Mandalorian ist also keine Vorgeschichte von der Skywalker Saga und Grogu macht im alter auch keine Zeitreise und wird zu Yoda dann.

Grogu ist ein Wesen, das der gleichen unbekannten Spezies wie Jedi-Meister Yoda angehört. Von den Fans wird er daher inoffiziell „Baby Yoda“ genannt. *Wikipedia

Baby yoda

Sowas geht doch schon super seit dem iPhone 10 mit dem FaceID Sensor, inkl. Ausgabe als STÖ Datei.

Qualitativ kein Vergleich… sowohl die FaceID Sensor als auch Lidar sensor sind ein gespielter Witz dagegen. Da ich selbst 3D Modele auf diese Weise erstellen, kann ich dir sagen, das es mit Photogrammetrie und teils Kostenloser Software zu deutlich besseren ergebnissen kommt, als mit den benannten Sensoren die absoluten Mist abliefern.

Nice, demnächst verschicken die Leute dann dickpics in AR hahaha

:-0

Alles schön und gut, aber gibt es ein passendes „Werkzeug/ Hardware“, die ein Objekt in kleinsten Schritten um seine Achse dreht und dann die entsprechenden Fotos macht???

Natürlich gibt es das jetzt schon. Aber das kann sich eben nicht jeder leisten.

Daher bietet Apple nun eine einfachere Methode dafür an.

Es handelt sich hier um Photogrammetrie, ein Verfahren, das schon sehr lange z.B. in Software wie Metashape eingesetzt wird. Sehr rechenintensiv und damit zeitaufwändig. Apple rechnet da erstaunlich schnell!

Unter OSX kann man das ausprobieren, indem man die OSX Monterey Beta und diese Software installiert: https://github.com/eospi/Object-Capture-UI

Funktioniert super! Konvexe Körper benötigen nicht soviele Fotos wie Objekte mit vielen Überhängen, wo Details verdeckt werden und mit weiteren Fotos erfasst werden müssen.